AIサーバー

人工知能 サーバーとは何ですか?

人工知能とビッグデータの時代では、AIサーバーは、ディープラーニング、画像認識、自然言語処理をサポートするコアハードウェアプラットフォームです。従来のサーバーとは異なり、人工知能 サーバーは グラフィックプロセッサ/TPU アクセラレータカード、高メモリ帯域幅、高速相互接続テクノロジーを統合し、数千億のパラメータによるモデルトレーニングと推論を可能にします。

大手 人工知能 サーバー メーカーである 深セン 新通台 テクノロジー 共同., 株式会社. は、エッジ コンピューティングから大規模クラスターまでのシナリオを網羅し、世界中の顧客にカスタマイズされた 人工知能 コンピューティング ソリューションを提供することに重点を置いています。

AIサーバーと汎用サーバーの主な違い

あ汎用サーバーウェブサービスやデータベースなどの従来のタスク向けに設計されていますが、AIサーバー高同時並列コンピューティング向けに最適化されています。以下に主な比較を示します。

| パラメータ | AIサーバー | 汎用サーバー |

|---|---|---|

| プロセッサアーキテクチャ | マルチGPU/TPUアクセラレーション(例:NVIDIA A100、アム 本能) | CPUベース(例:インテル ゼオン、アム EPYC) |

| メモリ帯域幅 | HBM2E 3.2TB/秒 | DDR4 51.2GB/秒 |

| 代表的な用途 | ディープラーニングトレーニング、リアルタイム推論 | 仮想化、ファイルストレージ |

| エネルギー効率 (テラフロップス/W) | 15~20歳 | 2~5 |

たとえば、8 つの NVIDIA H100 グラフィックプロセッサ を搭載した 人工知能 サーバーは、1,000 テラフロップス の FP16 パフォーマンスを実現し、自動運転モデルのトレーニングに適しています。一方、インテル N100 プレックス サーバーなどの汎用サーバーは、中小企業のメディア ストリーミングのニーズに適しています。

効率的な冷却: i9-13900K CPU に最適な冷却ソリューション

AIサーバーのCPU冷却には、i9-13900K CPUピーク時の消費電力が 253W のこのシステムでは、高性能の冷却ソリューションが必要です。以下は、主流のオプションの比較です。

| 冷却タイプ | 冷却能力 (TDP) | 騒音(デシベル) | 価格帯(人民元) |

|---|---|---|---|

| 空冷(デュアルタワー) | 250W | 28~35 | 300~600 |

| 240mm 液体冷却 | 300W | 22~30 | 600~1,200 |

| 360mm 液体冷却 | 350W以上 | 20~28歳 | 1,000~2,000 |

深セン新通泰科技有限公司はCPUクーラー卸売サービス。銅製のコールドプレートと高流量ポンプを備えたカスタム 360mm 液体冷却システムは、全負荷時に i9-13900K の温度を 75°C 未満に維持しながら、一括調達コストを 30% 削減できます。

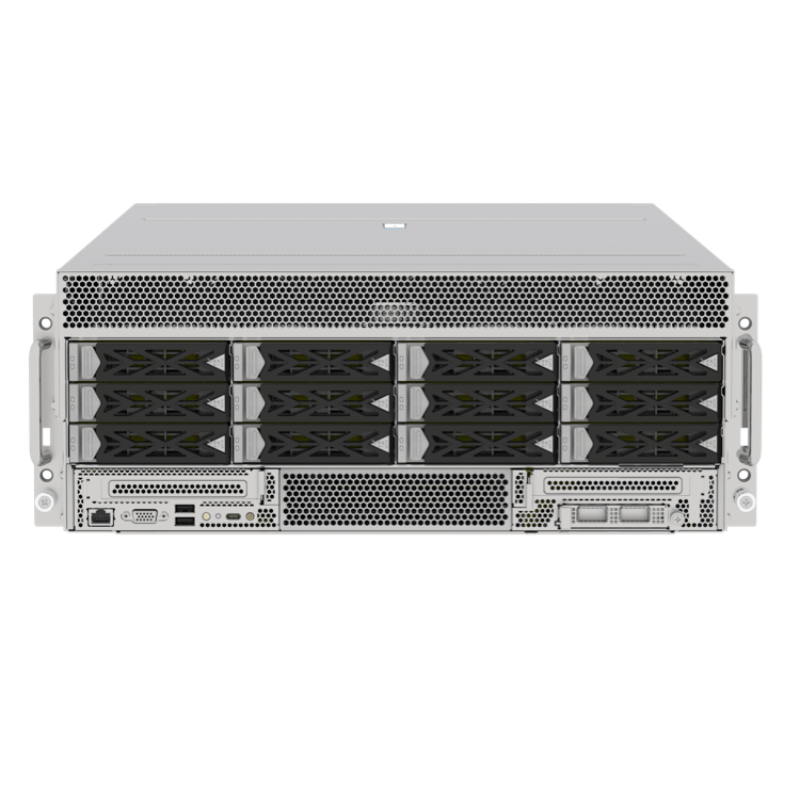

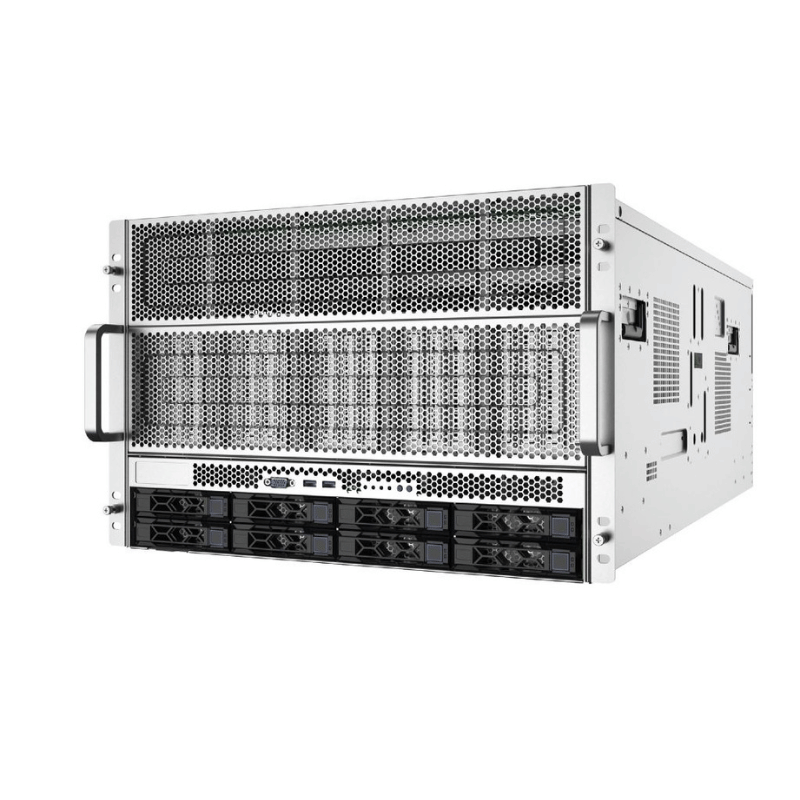

6U サーバー シャーシ: 高密度 人工知能 クラスターのハードウェア基盤

あ6U サーバーシャーシデータセンターでの高密度展開には不可欠であり、次のような利点があります。

✅スケーラビリティ: 12 個のフルハイト グラフィックプロセッサ スロットをサポートし、OCCP ニック 3.0 ネットワーク モジュールと互換性があります。

✅冷却設計: 最大 800 CFM のエアフローと液体冷却マニホールド統合を備えた 8 セットの 12038 ファンを備えています。

✅電源冗長性: デュアル 2,200W チタン電源 (効率 ≥ 96%) により、99.999% の可用性が保証されます。

| シャーシタイプ | グラフィックプロセッサ サポート | 冷却能力(キロワット) | 適用可能なシナリオ |

|---|---|---|---|

| 4Uシャーシ | 4 | 6~8歳 | エッジコンピューティングノード |

| 6Uシャーシ | 8~12歳 | 15~20歳 | スーパーコンピューティングセンター、AIトレーニング |

| 10Uシャーシ | 16歳以上 | 30歳以上 | 大規模HPCクラスター |

の6U サーバーシャーシモジュール設計を特徴とし、迅速なメンテナンスとホットスワップ可能な グラフィックプロセッサ を可能にし、さまざまな顧客向けの 1,000 カード 人工知能 クラスターに導入されています。

インテル N100 プレックス サーバーの 人工知能 エッジ コンピューティングの可能性

インテル N100 プレックス サーバ は軽量メディア サーバーとして位置付けられていますが、低消費電力 (TDP 6W) と 人工知能 アクセラレーション機能 (INT8 推論をサポートする統合 グラフィックプロセッサ) により、エッジ コンピューティング シナリオで独自の価値を発揮します。

主な特徴:

✅パフォーマンス: 4 コア、4 スレッド、最大ターボ周波数 3.4GHz、8K ビデオ デコードをサポートします。

✅AI推論: オープンVINO を通じて最適化されており、YOLOv5s モデル (≥15 FPs) を実行できます。

| シナリオ | N100 プレックス サーバー | 専用AIサーバー |

|---|---|---|

| 消費電力 | 10W | 500W以上 |

| 推論の遅延 | 50~100ミリ秒 | 5~20ミリ秒 |

| 導入コスト | 2,000円~5,000円 | 50,000円以上 |

深セン新通泰科技有限公司はエッジを提供する AIゲートウェイN100をベースに4G/5Gモジュールを統合し、スマート小売アプリケーションにおけるリアルタイムの顧客フロー分析に最適です。

人工知能 サーバーメーカーの選び方

人工知能 サーバー メーカーを選択するときは、次の点を考慮してください。

✅技術認定: NVIDIA ディージーエックス 準備ができて または MLパフォーマンス ベンチマーク ランキング。

✅カスタマイズ機能: 液体冷却の変更と異種コンピューティング (CPU + グラフィックプロセッサ + プログラマブルロジック) のサポート。

✅グローバルサービス: 24 時間 365 日のリモート サポートとスペアパーツ在庫カバー率 ≥95%。

| メーカータイプ | 利点 | 制限事項 |

|---|---|---|

| 国際ブランド | ブランドプレミアム、グローバルアフターセールス | カスタマイズサイクルが長い(8週間以上)、コストが高い |

| ローカルODMベンダー | 迅速な対応(2~4週間で納品)、コスト30%削減 | 技術的成熟度の検証が必要 |

ISO 9001 および ISO 14001 の認証を取得した 深セン 新通台 テクノロジー 共同., 株式会社. は、ピュー が 1.08 と低い液冷式 人工知能 サーバーを提供し、データセンターのエネルギー消費を 40% 削減します。

結論

ユニバーサルタイプのサーバーから専用のAIサーバーまで、企業はコンピューティングパワーのニーズ、消費電力の予算、運用能力に基づいてソリューションを選択する必要があります。深センXintongtai テクノロジー 共同., 株式会社.は、6U サーバーシャーシ設計、CPUクーラー卸売サプライチェーン、 そしてAIサーバー製造は、エッジからクラウドまで包括的なソリューションを提供します。i9-13900K を搭載した高性能ノードでも、インテル N100 プレックス サーバ をベースにした軽量ゲートウェイでも、当社は技術革新を通じて業界がインテリジェントな変革を実現できるよう支援します。